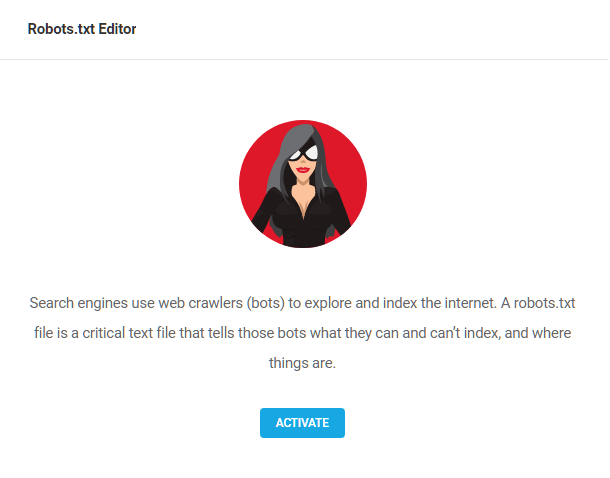

Cet outil vous permet d’éditer directement le fichier robots.txt de votre site sans avoir à entrer dans le système de fichiers via FTP ou cPanel.

Robots.txt est utilisé pour indiquer aux robots d’exploration ce qu’ils doivent ou ne doivent pas indexer. Par exemple, vous pouvez inclure des directives dans votre fichier robots.txt pour empêcher Google et d’autres moteurs de recherche d’indexer certains fichiers sur votre site Web (images, PDF, etc.) afin qu’ils n’apparaissent pas dans les résultats de recherche.

Commencez par activer le module :

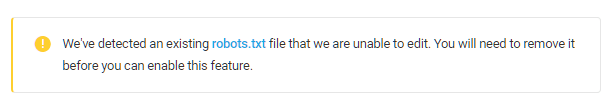

Important :

Cet outil ne peut pas être utilisé pour modifier un fichier robots.txt physique existant. Si un tel fichier existe déjà, le bouton Activer sera remplacé par un message vous avertissant que vous devrez supprimer ce fichier avant de continuer.

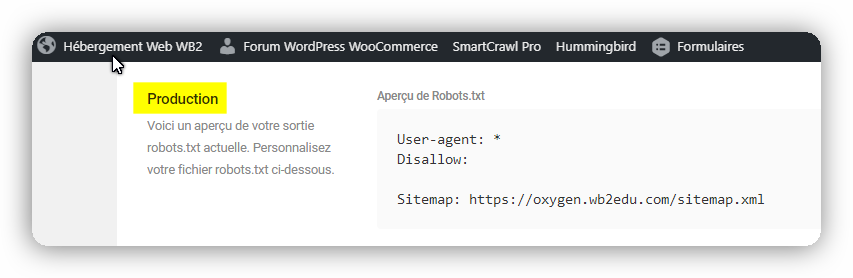

Production

La section supérieure ici vous donnera un lien vers l’emplacement du fichier virtuel robots.txt créé par le plugin et vous montrera le contenu actuel du fichier que les moteurs de recherche verront.

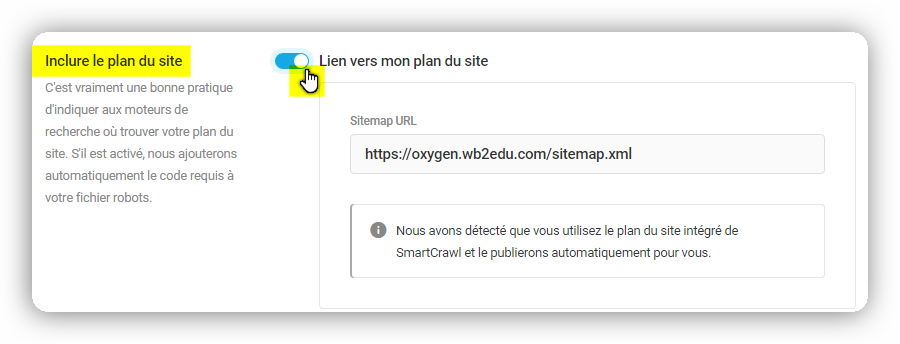

Le premier paramètre, Sitemap, vous permet d’inclure automatiquement l’URL du fichier sitemap.xml de votre site dans votre fichier robots.txt. C’est une bonne idée de s’assurer que cette option est activée et que l’URL sitemap.xml est entrée ici, afin que les moteurs de recherche sachent où trouver ce fichier lorsqu’ils l’utilisent pour explorer votre site.

Notez que si vous avez activé le module Sitemap dans SmartCrawl, cette URL sera automatiquement renseignée pour vous et ne pourra pas être modifiée.

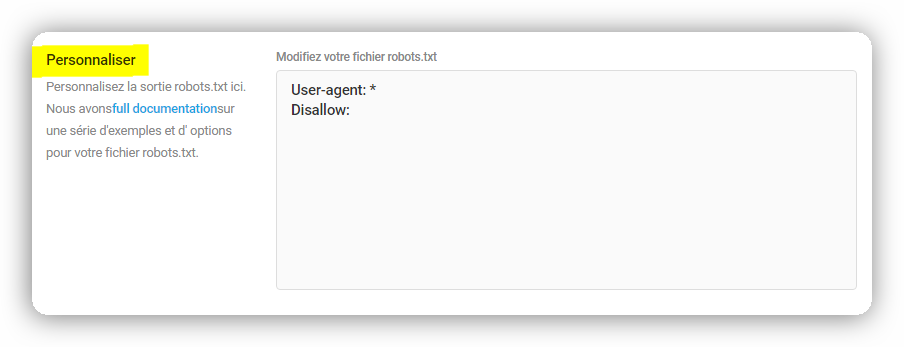

Le paramètre suivant, Personnaliser, vous permet d’ajouter toutes les directives dont vous avez besoin dans votre fichier robots.txt pour indiquer aux robots d’exploration ce qu’ils doivent faire sur votre site.

Par défaut, cette section ne contient que les éléments suivants, ce qui permet à tous les agents utilisateurs (moteurs de recherche) d’accéder et d’indexer tout le contenu :

User-agent: *

Disallow:

- User-agent: * signifie tous les (*) moteurs de recherche.

- Disallow: sans rien après, cela signifie que rien n’est interdit, donc l’accès à tout le contenu est autorisé.

Vous pouvez ajouter toutes les directives supplémentaires dont vous avez besoin dans cette section, mais vous pouvez la laisser telle quelle si vous n’avez pas besoin ou souhaitez restreindre l’accès du robot d’exploration Web.

Par exemple, si vous souhaitez empêcher les moteurs de recherche d’indexer les pages de panier et de paiement WooCommerce sur votre site, vous pouvez ajouter des règles comme celles-ci à votre fichier robots.txt :

Disallow: /*add-to-cart=*

Disallow: /cart/

Disallow: /checkout/

Disallow: /my-account/

Pour plus d’informations sur les directives robots.txt, veuillez consulter cet article pratique sur moz.com https://moz.com/learn/seo/robotstxt

Google et Wikipedia ont également de bons articles pour vous aider si nécessaire:

https://support.google.com/webmasters/answer/6062608?hl=fr

https://support.google.com/webmasters/answer/6062596?hl=fr

https://en.wikipedia.org/wiki/Robots_exclusion_standard#About_the_standard